来源:芯东西

芯东西(公众号:aichip001)

作者 | ZeR0

编辑 | 漠影

芯东西8月6日报道,昨晚,“英伟达劲敌”之一Groq甩出了两个重磅新闻:

1、获得6.4亿美元D轮融资,由贝莱德领投,思科、三星旗下风投机构等跟投,估值达28亿美元(折合约200亿人民币)。

2、请来2018年图灵奖得主、“深度学习三巨头之一”、纽约大学教授、meta副总裁兼首席AI科学家杨立昆(Yann LeCun),担任技术顾问。

杨立昆虽然经常接地气地跟马斯克隔空互喷,但论起AI学术界的地位、产学双栖的实力,没有几人能比这位AI重要奠基人物享有更高的声誉,而且是前沿世界模型的“头号代言人”。

天天喊话AI产业大佬的Groq,这回真“傍”上了一位重量级大牛。

这家由谷歌TPU核心成员搭伙创办的创企堪称AI芯片界的整活儿大师,刚成立时主打神秘感,把技术和产品瞒得密不透风,吊足了业界的胃口。

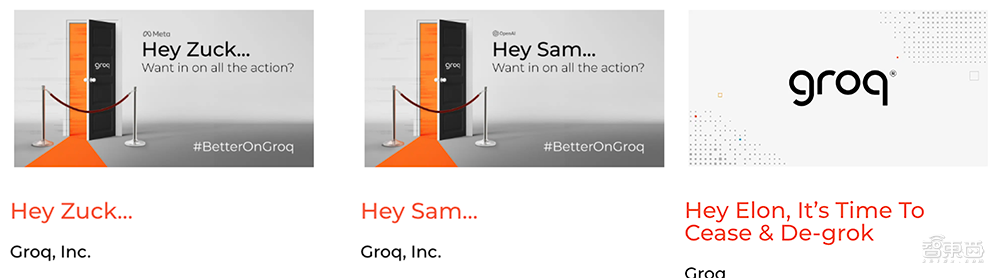

后来市场不及预期,生存遇到危机,Groq痛定思痛,在抓住生成式AI这根救命稻草后画风突变,打出“世界最快推理”的招牌,接连喊话“宇宙网红”马斯克、OpenAI CEO萨姆·阿尔特曼、meta创始人兼CEO马克·扎克伯格,屡屡挑衅英伟达,跟刚成立时的低调作风判若两司。

除了搏眼球功夫深,它的吸粉能力也可圈可点,不少知名大佬都给它打过广告。

杨立昆说“Groq芯片真的很有市场”。扎克伯格宣布Groq将为meta Llama 3.1大语言模型提供推理芯片。原阿里副总裁、创办AI Infra创企Lepton AI的贾扬清自称是“Groq超级粉丝”。

这次新融资后,硅谷AI芯片三大独角兽——Groq(估值28亿美元)、Cerebras(估值40亿美元)、SambaNova(估值51亿美元)——终于在200亿人民币估值俱乐部会师。

一、融资金额比预期翻倍,今年销售额可能达1亿美元

全球最大AI计算巨头英伟达的市值已经一度飙升到3万亿美元,2023年营收达609亿美元。

相比之下,Groq的体量还很小,根据《福布斯》看到的财务文件,这家创企2023年的销售额仅为340万美元,净亏损达到8830万美元。

不过消息人士称,Groq预计今年销售额可能乐观地达到1亿美元。

但走到今天这一步,对于这家AI芯片创企来说已经是时来运转、柳暗花明了。

别看Groq是现在叫板英伟达最起劲儿的AI芯片创企之一,在ChatGPT引爆全球生成式AI热潮前,Groq曾经历了一段很难熬的日子。

据联合创始人乔纳森·罗斯 (Jonathan Ross)回忆,Groq有好几次差点“死掉”,在2019年低谷期时再有一个月就没钱了。

以至于罗斯后来都懊悔Groq创办得有点早。

▲Groq创始人乔纳森·罗斯

▲Groq创始人乔纳森·罗斯

2016年底,包括罗斯在内,谷歌TPU十位核心成员中的八人悄悄离职,合伙创立Groq。

谷歌TPU,AlphaGo击败世界围棋冠军背后算力的核心功臣,一战成名,带动起全球专用AI芯片市场的火热。它的核心设计人员出走创业,受关注程度可想而知。但Groq创立初期一路神隐,悄悄熬过了一段缺钱窘境,直到2019年年底才偶尔发发博客文章,满足一下业界的好奇心。

2017年,Groq被报道获得1030万美元启动资金,这是它第一次出现在公众视野。之后找到新投资者似乎就变得困难,Groq又经历3轮融资,但累计金额仅6000多万美元。

直到2021年4月,Groq终于拿到一笔相对大的3亿美元融资,总融资额超过3.6亿美元,估值超过10亿美元,跻身芯片独角兽俱乐部。

时隔3年,Groq如今一口气获得6.4亿美元新融资,总融资额越过10亿大关,估值暴涨到28亿美元,比上次融资后估值的两倍还多。

罗斯新发的推文一股凡尔赛味儿:我们起初打算融资3亿美元来着,为了能在2025年第一季度末部署10.8万块IPU投入生产,谁承想筹到2倍的资金,所以也在扩大云计算和核心工程团队。

二、跑Llama 3 70B,快过GPT-4o mini

在发布旗舰大语言模型Llama 3.1 405B时,扎克伯格发表一篇题为《开源AI是前进的道路》的文章,其中提到“像Groq这样的创新者已为所有新模型构建了低延迟、低成本的推理服务”。

罗斯称,相比用英伟达GPU,LPU集群将为大语言推理提供更高吞吐量、更低延迟、更低成本。

Groq自研的LPU(语言处理单元)旨在克服大语言模型的计算密度和内存带宽瓶颈,计算能力超过GPU和CPU,能够减少计算每个单词所需时间,更快生成文本序列。

在ChatGPT掀起生成式AI热潮后,经历过濒临生存危机的Groq开启暴走模式,疯狂宣传自家AI推理引擎LPU,号称做到“世界最快推理”,并在社交平台上频繁发文和转发合作伙伴们、网友们对其LPU的实测结果和好评。

今年2月,根据Groq及一些网友分享的技术演示视频,在LPU上运行大语言模型Mixtral 8x7B-32k生成回答只用时11秒,而OpenAI ChatGPT 4需要花费长达1分钟。

AI写作创企HyperWriteAI CEO Matt Shumer称LPU“快如闪电”、“不到1秒写出数百个单词”、“大语言模型的运行时间只有几分之一秒”。

根据Artificial Analysis今年7月公布的数据,Groq以大约340tokens/s的输出速度提供Llama 3 70B,比GPT-4o mini的两倍还快。

通用全球资本参与了Groq的多轮融资,其联合创始人埃米什·沙阿(Aemish Shah)称Groq产品的推理速度“明显优于市场上任何其他产品”。

在即时AI推理速度的吸引下,大批开发者涌向Groq。

今年3月,Groq推出了一个由LPU驱动的开发者平台GroqCloud。开发者可以通过这一平台租用LPU芯片,而无需直接购买。

该平台提供meta Llama 3.1、OpenAI Whisper Large V3、谷歌Gemma、Mistral Mixtral等开源模型,支持在云实例中使用其芯片的API。

为了吸引开发者,Groq提供免费访问:第一个月就有7万人注册。现在已有超过36万名开发人员在GroqCloud上创建AI应用,数量还在增加。

Groq最近刚刚聘请了英特尔前代工业务前负责人、惠普前首席信息官斯图尔特·潘恩(Stuart Pann)担任首席运营官。潘恩对Groq的增长持乐观态度:在GroqCloud的客户订购中,超过1/4的客户要求支付更多的计算能力。

Groq打算用新融资扩大其TaaS(Token即服务)产品的版图,并为GroqCloud添加新的模型和功能。

三、架构设计不走寻常路:没HBM、没CoWoS,比GPU效率高

Groq宣称LPU在运行大语言模型及其他生成式AI模型等解决方案时,能效至少是GPU的10倍。

GroqChip1芯片采用14nm制程,搭载230MB片上共享SRAM,内存带宽达80TB/s,FP16算力为188TFLOPS,int8算力为750TOPS。

与很多大模型芯片不同的是,Groq的芯片没有HBM、没有CoWoS,因此不受HBM供应短缺的限制。它采用了单核心时序指令集计算机架构,无需像使用HBM的GPU那样频繁从内存中加载数据,能有效利用每个时钟周期,降低成本,运行大语言模型的速度更快。

▲传统GPU内存结构

▲传统GPU内存结构

▲Groq芯片内存结构

▲Groq芯片内存结构

实时AI推理是一个专门的系统问题。硬件和软件都在速度和延迟方面发挥作用。再多的软件也无法克服芯片设计和架构造成的硬件瓶颈。

Groq用软件定义硬件方法将执行控制和数据流控制的决策步骤从硬件转移到了编译器。通过精确调度每个内存负载、操作和数据包传输,确保最高的性能和最快的系统响应,释放了额外的芯片空间和处理能力。

▲Groq的简化软件定义硬件方法释放了额外的芯片空间和处理能力

▲Groq的简化软件定义硬件方法释放了额外的芯片空间和处理能力

编译器会将模型划分为较小的块,这些块在空间上映射到多个LPU芯片上。就像一条计算装配线,每个LPU集群都设置为运行特定的计算阶段,并将执行该任务所需的所有数据存储在其本地片上 SRAM内存中,数据传输从LPU到LPU,不需要外部HBM芯片和外部路由器。

这种高效的流水线架构之所以可行,是因为LPU推理引擎具有完全确定性,系统准确地知道每个芯片上每个阶段发生的情况,使流水线能够以最高效率运行。

▲LPU(右)的可编程流水线架构与GPU(左)方法更快更高效

▲LPU(右)的可编程流水线架构与GPU(左)方法更快更高效

根据Groq的描述,GPU的工作方式是在小型芯片集群中运行,每个集群执行生成token所需的每个顺序计算阶段。在每个阶段,GPU从另一个芯片上的HBM中检索执行该阶段所需的所有数据,完成任务后,数据返回到片外HBM,所有传输数据都需要来自外部芯片的指示,既低效又昂贵。

Groq编译器将操作直接映射到LPU,无需任何手动调优或实验,因此LPU的设计非常简单。基于张量流式架构,LPU不需要CUDA或内核。

▲单个LPU架构

▲单个LPU架构

“我们的目标是在硬件上投入的每一美元都能获得全额回报,我们不想赔钱。”罗斯说。

Groq从两年前开始销售芯片,陆续获得客户,已经与meta、三星等多家公司以及沙特阿拉伯等主权国家合作生产和推出其芯片。

阿贡国家实验室曾使用Groq的芯片研究核聚变。今年早些时候,Groq与沙特阿美数字公司达成合作,计划在中东和北非地区建立最大的AI推理即服务计算基础设施之一;并与欧洲可持续能源公司Earth Wind & Power合作,将在挪威数据中心部署数万块IPU。

目前Groq正在推进下一代芯片的研发生产,去年8月宣布将与晶圆代工厂格芯签订生产4nm IPU的合同。

根据此前报道,Groq下一代芯片的能效预计相较前一代提高15~20倍,尺寸将变得更大。执行相同任务所需的芯片数量也将大幅减少。

在对meta Llama 2 70B模型做推理基准测试时,Groq将在9个机架中576块芯片互连。而到2025年完成这一任务,可能只需在2个机架使用大约100块芯片。

结语:AI芯片越来越热闹了

随着生成式AI热潮持续,AI芯片市场前景可期,Groq面临的竞争也日趋激烈。

根据Groq在今年4月发表的博客文章,到2027年,AI芯片TAM市场预计将达到1194亿美元,当前约40%的AI芯片用于推理,应用程序达到成熟后通常会将90-95%的资源分配给推理,这表明随着时间的推移,推理市场会变得更大。

目前英伟达把控着70%~95%的AI芯片市场。谷歌、微软、亚马逊、meta等科技巨头均在自研AI芯片。OpenAI今年筹备启动一项AI芯片制造计划。Arm也被传将成立一个AI芯片部门。

多家AI芯片企业均有新动作。去年年底,美国AI芯片创企D-Matrix获得1.1亿美元B轮融资;今年6月,美国AI芯片创企Etched宣布完成1.2亿美元A轮融资,美国晶圆级芯片独角兽Cerebras秘密申请IPO;7月,日本软银集团以6亿美元收购英国AI芯片独角兽Graphcore。

据外媒报道,一位风险投资家拒绝参与Groq的新融资,理由是Groq的方法虽然新颖,但从长远来看,其知识产权并不可靠。也有一些人质疑Groq大规模生产芯片的成本效益。

要打消市场的种种疑虑,Groq仍需竭力证明自家产品在推理市场的商用实力。

毕竟这么多年来,“英伟达劲敌”越来越多,但市值3万亿美元的英伟达始终只有一个。

来源:Groq,TechCrunch,Forbes

免责声明:本网信息来自于互联网,目的在于传递更多信息,并不代表本网赞同其观点。其内容真实性、完整性不作任何保证或承诺。由用户投稿,经过编辑审核收录,不代表头部财经观点和立场。

证券投资市场有风险,投资需谨慎!请勿添加文章的手机号码、公众号等信息,谨防上当受骗!如若本网有任何内容侵犯您的权益,请及时联系我们。

相关文章

-

AI芯片独角兽宣布杨立昆加盟!估值暴涨到200亿

2024-08-070阅读

-

AI手机,苹果摸着安卓过河?

2024-08-070阅读

-

网易云音乐严厉打击刷量黑产,维护音乐传播良好生态

2024-08-070阅读

-

从赛场到市场:巴黎奥运上的中国元素与多产业蓬勃发展

2024-08-070阅读

-

百度地图崩了,客服回应称系统出现错误、正在紧急修复

2024-08-070阅读

-

界环 AI 音频眼镜新品外观公布:8 框 14 色,30.7g 轻量化设计

2024-08-070阅读

-

英伟达驱动暗示《最终幻想16》PC版即将发布,最快科隆游戏展公布

2024-08-070阅读

-

群联全面展示 Pascari 企业级固态硬盘,含 100DWPD 超高耐久型号

2024-08-070阅读

-

存储芯片大爆发:年增长82%,美日韩吃肉,中国厂商喝汤?

2024-08-070阅读

-

分期乐 美团优选 有赞 闲鱼等入选7月数字零售十大典型投诉案例

2024-08-070阅读