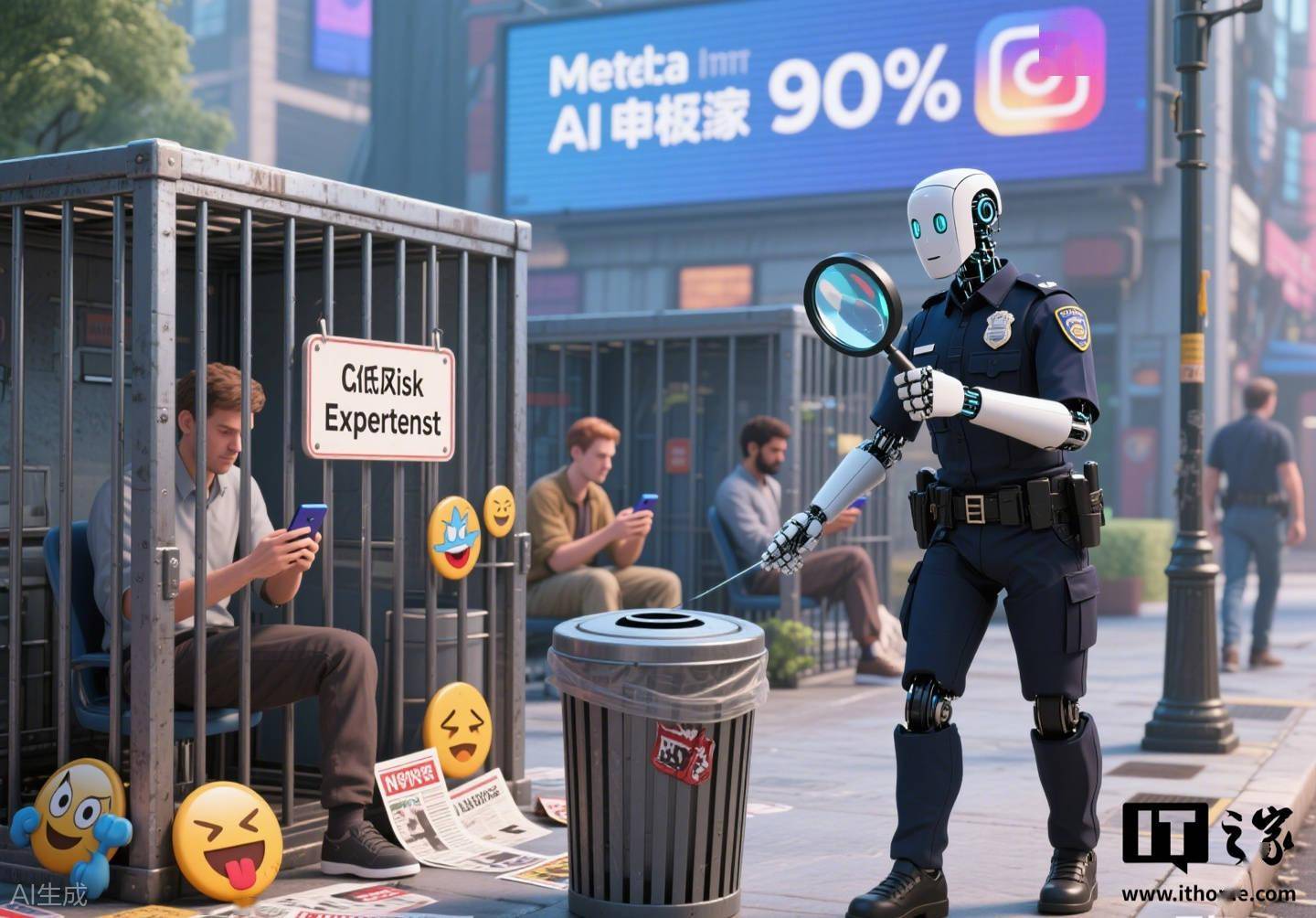

6 月 1 日消息,据美国国家公共广播电台(NPR)报道,社交媒体巨头 meta 正在计划将其产品潜在风险评估的任务从人工审核转向更多依赖人工智能(AI),以加快审核流程。内部文件显示,meta 的目标是让高达 90% 的风险评估工作由 AI 完成,甚至包括涉及青少年风险和“诚信”领域的评估,后者涵盖暴力内容、虚假信息等多个方面。然而,与 NPR 交流的现任和前任 meta 员工警告称,AI 可能会忽视一些人工团队能够识别的严重风险。

长期以来,meta 旗下包括 Instagram 和 WhatsApp 在内的平台的更新及新功能,在面向公众推出之前都会经过人工审核。但据报道,过去两个月,meta 大幅增加了对 AI 的使用。如今,产品团队需要填写一份关于其产品的调查问卷,并提交给 AI 系统进行审核。该系统通常会提供“即时决策”,指出其识别出的风险领域。产品团队随后需要解决 AI 提出的要求,才能发布产品。

一位 meta 前高管表示,减少审核力度意味着“你正在创造更高的风险。产品变更的负面外部效应在开始造成问题之前更不可能被阻止”。meta 在一份声明中回应称,公司仍会利用“人类专业知识”来评估“新颖且复杂的问题”,而将“低风险决策”交给 AI 处理。

注意到,meta 几天前公布了其最新季度诚信报告,这是该公司今年早些时候改变内容审核和事实核查政策后的首份报告。报告显示,在政策调整后,被删除的内容数量如预期般有所下降,但霸凌和骚扰行为、以及暴力和血腥内容却略有上升。

免责声明:本网信息来自于互联网,目的在于传递更多信息,并不代表本网赞同其观点。其内容真实性、完整性不作任何保证或承诺。由用户投稿,经过编辑审核收录,不代表头部财经观点和立场。

证券投资市场有风险,投资需谨慎!请勿添加文章的手机号码、公众号等信息,谨防上当受骗!如若本网有任何内容侵犯您的权益,请及时联系我们。

相关文章

-

我国量子直接通信领域新突破:300公里级全连接!

2025-06-025阅读

-

下肢瘫痪动漫爱好者通过“外骨骼机器人”展现哪吒经典形象

2025-06-025阅读

-

苹果 iPad 加入自助维修服务,外媒直呼定价高昂“修不起”

2025-06-025阅读

-

线上线下渠道融合加速!白象赋能经销商,双线联动撬动市场份额

2025-06-025阅读

-

消费Insights | 霸王茶姬上市后首份财报:两个疑惑,找到答案

2025-06-025阅读

-

Steam玩家Win11占比创58.3%新高!RTX 3060老将不死

2025-06-025阅读

-

realme 真我 C73 手机海外发布:天玑 6300 + 4GB RAM

2025-06-025阅读

-

Anthropic 开源神经网络追踪工具,可生成归因图

2025-06-025阅读

-

“13**0000000”手机号卖了61.2万:8元套餐 无最低自费要求

2025-06-025阅读

-

消息称苹果“快捷指令”应用将引入 Apple 智能

2025-06-025阅读