图像模型开源还得是FLUX!

Black Forest Labs刚刚宣布开源旗舰图像模型FLUX.1 Kontext[dev],专为图像编辑打造,还能直接在消费级芯片上运行。

只有小小的12B,更少的参数,更快的推理,性能更是媲美GPT-image-1等一众闭源模型。

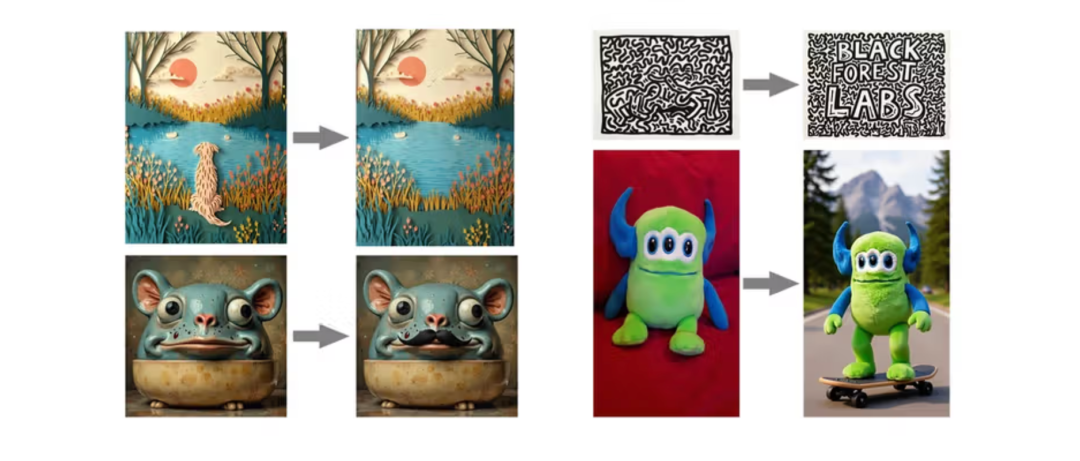

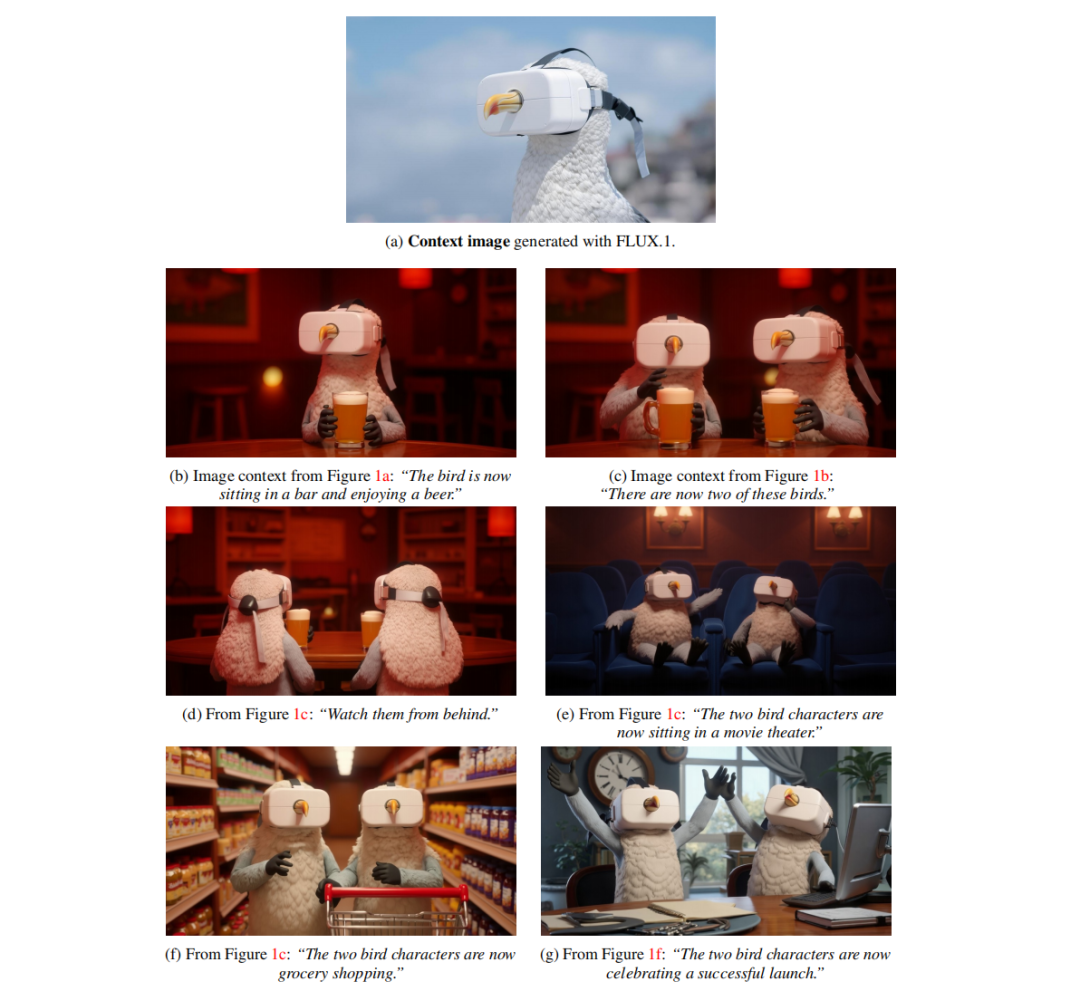

现在FLUX.1 Kontext[dev]可以让小狗迅速离开画面,为小老鼠戴上胡须,添加文字、修改背景也不在话下。

或者多次输入指令,直到让小哥成为酒吧里最靓的崽(bushi),直到让画面符合咱们需求。

具体来说,FLUX.1 Kontext[dev]的主要特点有:

可以根据编辑指令直接更改现有图像,以及进行精确的本地和全局编辑。

不用做任何微调,就能直接引用里面的人物角色、风格样式和物品元素。

允许用户通过多次连续编辑优化图像,同时将视觉漂移降到最低。

专门为NVIDIA Blackwell进行了权重优化。

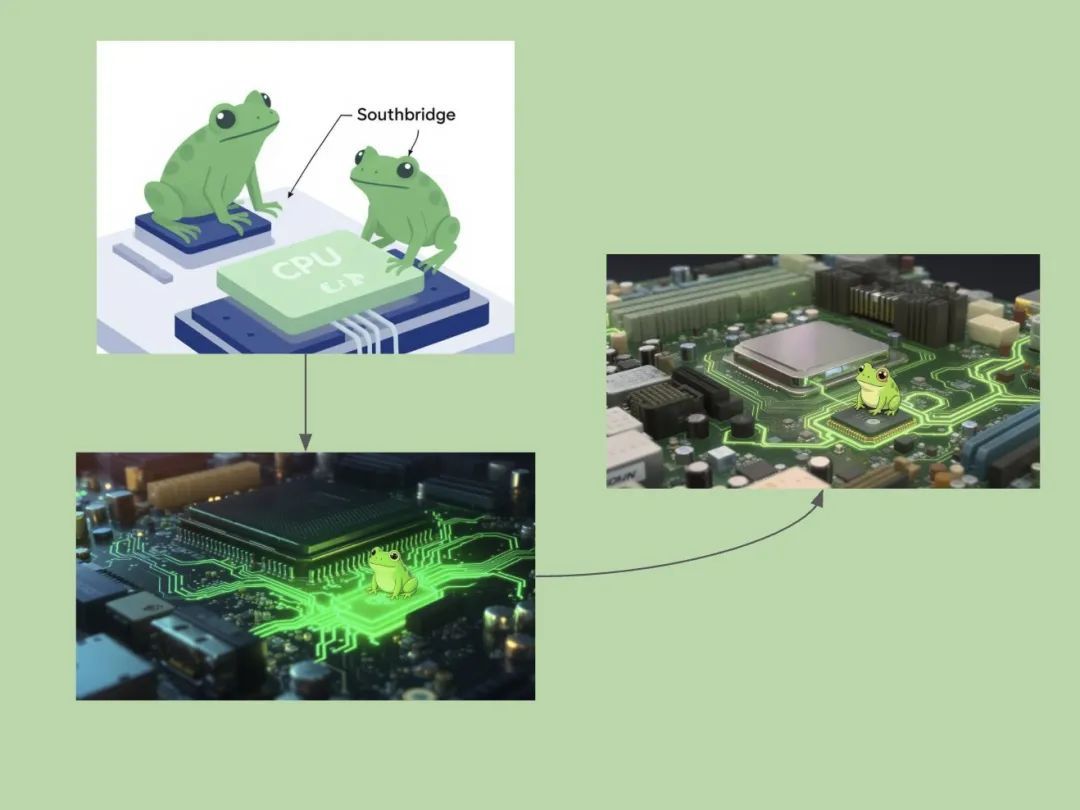

网友们也立马上手试玩,制作了一个旅行的CPU青蛙?

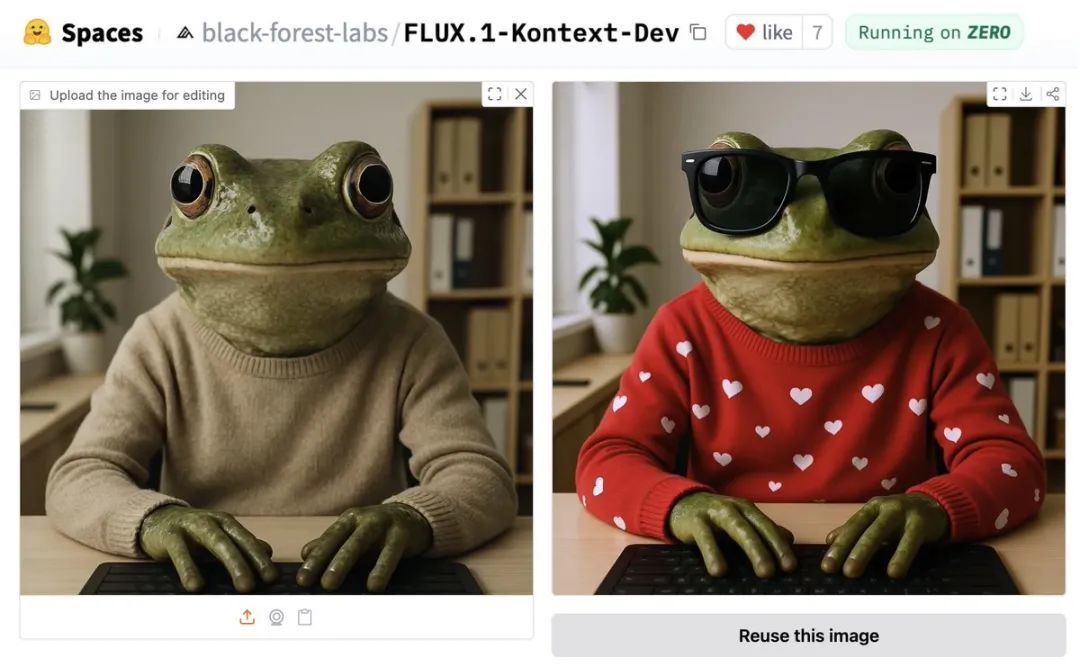

旅行必备的墨镜,还有抗寒的帅气红色毛衣也要准备妥当。(蛙蛙:出片,我势在必行)

或者copy一下自己喜欢的动漫角色。

轻轻松松店铺打烊,结束打工人完美的一天~(doge)

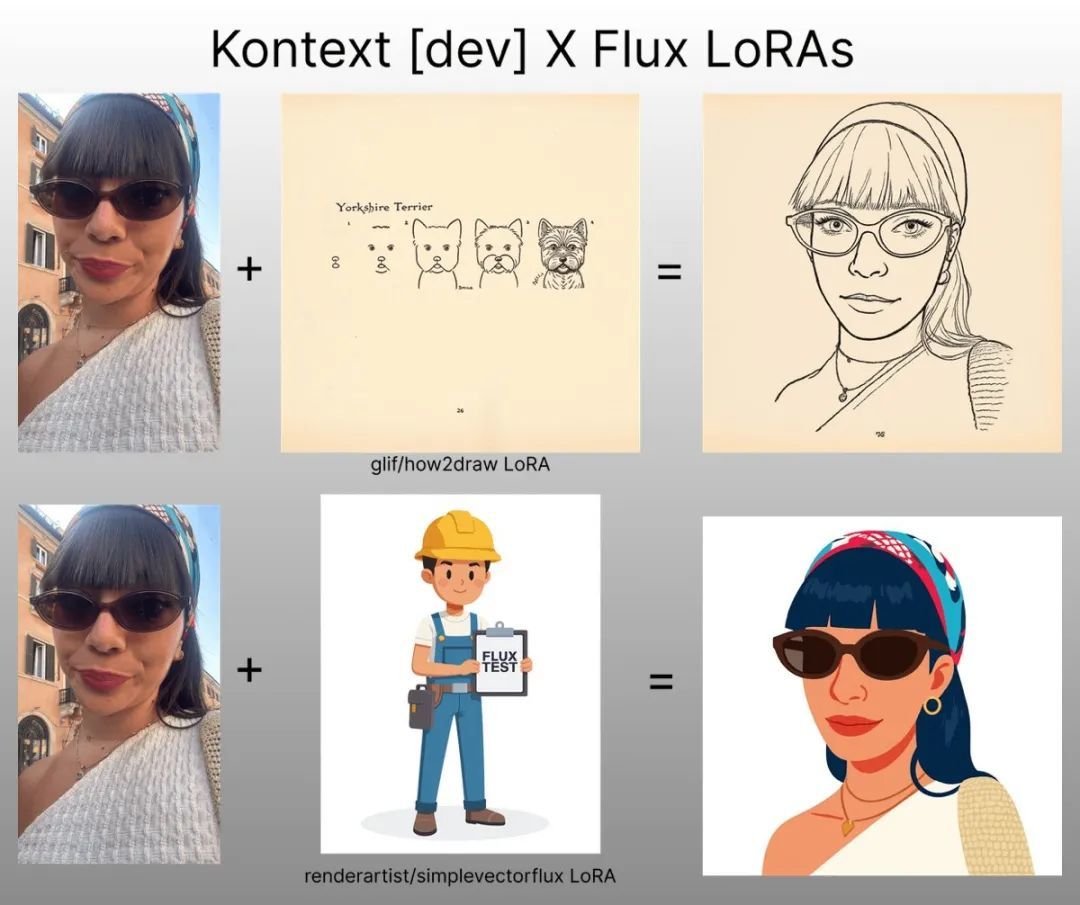

还有网友脑洞大开,试着和LoRA结合,造出了一个Kontext风格化肖像制作APP。

现在FLUX.1 Kontext[dev]还完全支持ComfyUI。

温馨提示,官方直接开放了试玩API,只需点击文末链接、上传图片就可以立即爽玩!

网友看罢表示,Black Forest Labs不愧是图像届的DeepSeek。

FLUX.1 Kontext的开放权重变体

FLUX.1 Kontext模型上个月一经发布,就因为其强大的上下文生成和编辑功能广受好评。

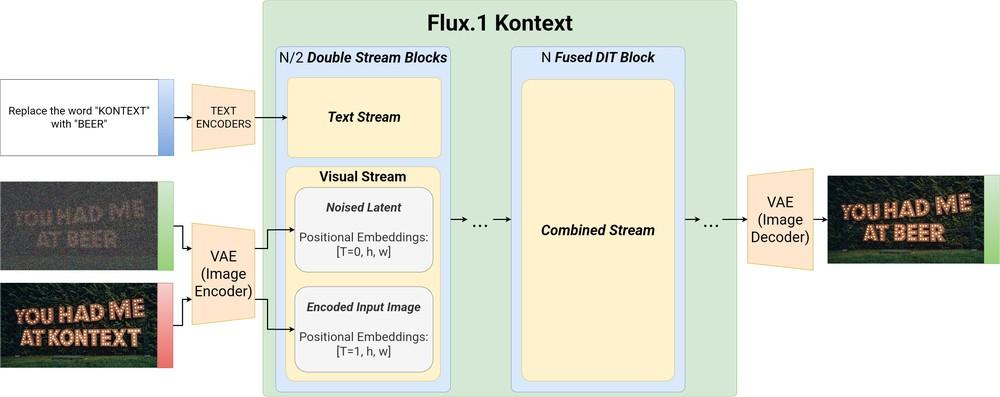

与现有的文本到图像模型不同,FLUX.1 Kontext系列执行上下文图像生成,可以直接使用文本和图像进行提示,并无缝提取和修改视觉细节。

目前已经发布了适合快速迭代的专业版FLUX.1 Kontext[pro]和高配版FLUX.1 Kontext[max]。

FLUX.1 Kontext[dev]作为FLUX.1 Kontext最新发布的开源版本,不仅继承了其图像生成的优势,它还更专注于编辑任务,可以直接在消费类硬件上运行。

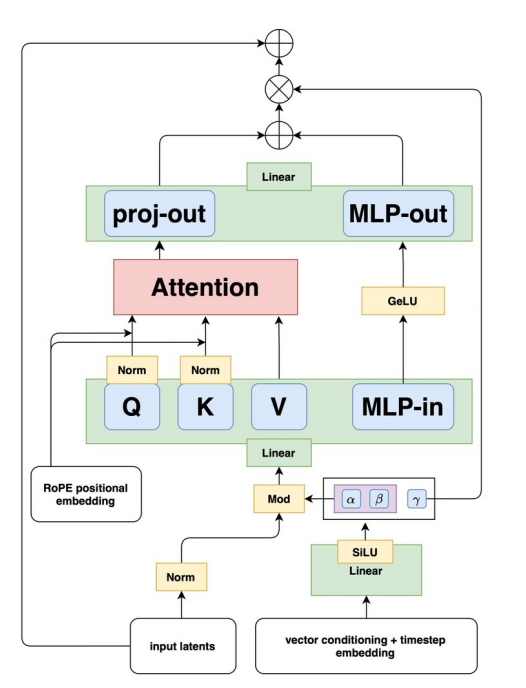

首先模型架构上,依旧基于的是FLUX.1模型,它是一种在图像自动编码器的潜在空间中训练的整流流Transformer模型,由双流块和单流块混合构建而成。

在此基础上,FLUX.1 Kontext[dev]采用标记序列构建和位置信息编码进行优化:

标记序列构建:图像通过冻结的FLUX自动编码器,编码成潜在的上下文图像标记,并输入到模型的视觉流中。

位置信息编码:通过三维旋转位置嵌入(3D RoPE)对位置信息进行编码,为上下文标记的嵌入提供恒定偏移量。并将其视作为虚拟时间步,以清晰分离上下文和目标块,同时保持它们的内部空间结构。

然后使用整流流匹配损失进行训练,在训练时从FLUX.1的文本到图像检查点开始,收集并整理数百万个关系对进行模型优化。

优化后得到的流匹配模型进行潜在对抗扩散蒸馏(LADD),在减少采样步骤的同时提高样本质量,使FLUX.1 Kontext[dev]更高效。

最终得到的FLUX.1 Kontext[dev]模型包含120亿参数,可以更专注于编辑任务,支持迭代编辑,可以在各种场景和环境中保留角色特征,并允许用户进行精确的局部或全局编辑。

图像编辑新标准

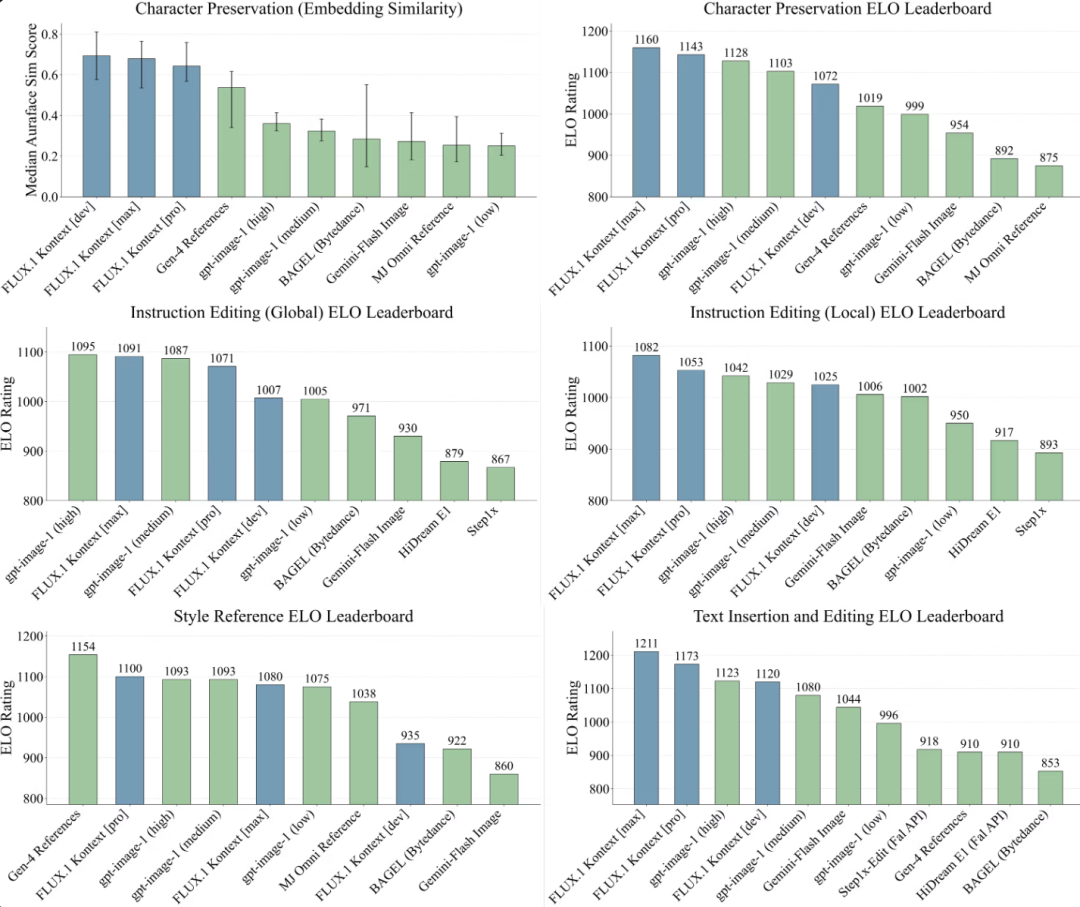

实验引入自研的KontextBench基准进行模型性能验证,该基准包含1026个图像-提示对,涵盖局部编辑、全局编辑、角色参考、风格参考和文本编辑五个任务类别。

结果显示FLUX.1 Kontext[dev]在许多类别上都优于现有的开放式图像编辑模型和封闭模型,例如Bytedance Bagel、HiDream-E1-Full以及OpenAI的GPT-image-1等。

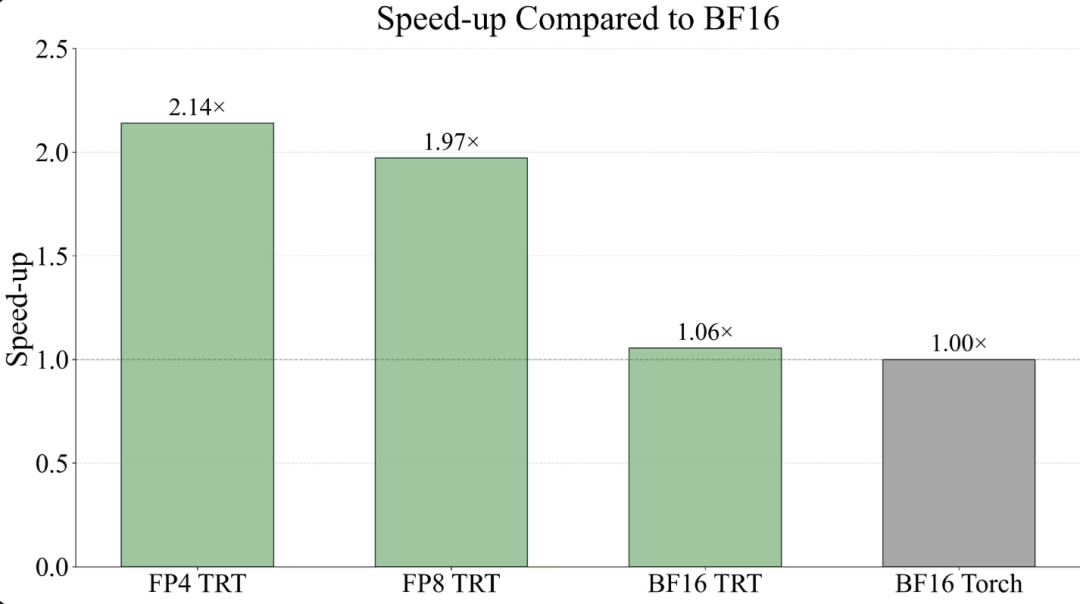

另外,FLUX.1 Kontext[dev]还专门针对新的NVIDIA Blackwell架构进行了TensorRT权重优化,可以在保持高质量的图像编辑性能的同时,极大地提高推理速度并减少内存使用量。

官方还提供了BF16、FP8和FP4 TensorRT的权重变体,用户可以自行对其速度、效率和质量进行调整,综合确保FLUX.1 Kontext[dev]充分利用最新的硬件功能。

在实际用户的反馈中,也发现FLUX.1 Kontext[dev]的推理速度较前代提升了4至5倍,模型在NVIDIA H100 GPU上运行,通常5秒内能够完成,在Replicate上的运行成本约为0.0067USD,或每1USD运行149次。

但是也有网友提到,在MacBook Pro的芯片上运行时,迭代时间较长,每次迭代都需要1分钟左右。

免责声明:本网信息来自于互联网,目的在于传递更多信息,并不代表本网赞同其观点。其内容真实性、完整性不作任何保证或承诺。由用户投稿,经过编辑审核收录,不代表头部财经观点和立场。

证券投资市场有风险,投资需谨慎!请勿添加文章的手机号码、公众号等信息,谨防上当受骗!如若本网有任何内容侵犯您的权益,请及时联系我们。

相关文章

-

“致命”电芯:非3C充电宝集体变砖头背后的猫腻

2025-06-304阅读

-

福特CEO:中国电动汽车的发展让我自惭形秽

2025-06-304阅读

-

梅赛德斯-AMG将为电动汽车带来油车“情绪价值”:引入模拟换挡及声浪

2025-06-304阅读

-

大疆:旗下无人机电池不属于充电宝设备,飞机安检要求不受影响

2025-06-304阅读

-

安克的锅,凭啥让消费者来背?

2025-06-304阅读

-

比亚迪25款腾势D9汽车获OTA升级 新增云辇预瞄等功能

2025-06-304阅读

-

被扣下的无3C充电宝如何处置 有机场称义卖后金额上交国库

2025-06-304阅读

-

外贸获客困境重重,如何突围?

2025-06-304阅读

-

沈阳数帆教育咨询有限公司:短视频时代,电商培训如何适应新趋势?

2025-06-304阅读

-

下半年还会发餐饮消费券吗?上海市商务委正在研究可行方案

2025-06-304阅读