报道

编辑:定慧

即便在Transformer与ChatGPT尚未诞生的年代,Ilya已敏锐预见深度学习的广阔前景,展现出令人叹服的远见与清醒。这是一段10年前Ilya对于如今AI时代的预言。

Ilya Sutskever因在深度学习方面的远见卓识而闻名。

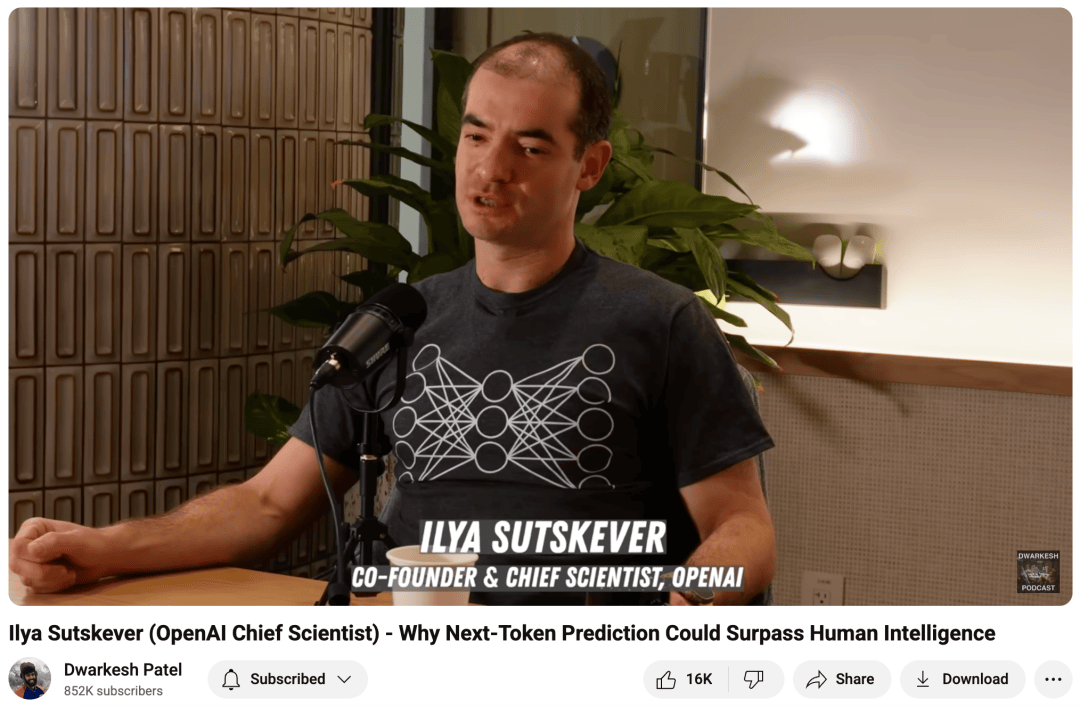

他现在许多广为流传的言论其实都来自于他在2023年参加Dwarkesh播客时的发言。

此后,直到2025年Ilya创办SSI后,几乎不再有公开的言论,此前曾探讨过Ilya的去向。

最近,一位名为Nathan Lambert的博主声称他收到了一段Ilya在10年前,也就是2015年谈论深度学习的语音片段。

令他感到震惊的是,Ilya在那么多年前就已准确预见了这一切,尤其是他的直觉从那时至今几乎没有任何改变。

在进行资料整理,同样震惊我们的是:

早在2015年,Ilya对于深度学习的理解就已经远超如今绝大部分人(即使是10年后今天)。

这个视频片段来自一个已经停播的博客节目《Talking Machines》,我们在其官网找到最初的采访录音。

此时的Ilya还是谷歌的研究员,节目中谈论了他的工作、他是如何对机器学习产生兴趣的,以及为何机器学习(Machine Learning)会和魔法思维(Magical Thinking)产生联系。

现在就让我们将时间回拨10年,看看当年的Ilya是如何洞察深度学习的。

在编辑这篇文章时,我们也惊讶地发现,即使只是通过文字记录,Ilya的观点历经10年岁月洗礼,依然鲜明犀利。

数学出身的Ilya,认为「机器学习」违反直觉

Ilya首先讲述了他通往人工智能的道路,对于这样一位才华横溢的人物来说,这并不令人意外。

我十几岁时就一直对人工智能感兴趣。

我觉得那非常棒而且引人入胜。之后我继续攻读了数学专业本科。

当你学习数学的时候,你会深知数学注重的是证明事物。

如果你看到某种规律,在没有经过证明之前,它并不意味着就是正确的。

因此,对于拥有数学背景的我来说,学习(机器学习)似乎是非常违反直觉的,因为学习强调的是进行归纳推理,而这些归纳步骤看起来很难用严谨的方法去解释清楚。

如果你习惯于严格地证明结果,那么归纳似乎几乎就像魔法一样。

因此,我当时对学习特别感兴趣,因为我深知人类具备这种能力,而从单纯的数学角度来看,学习似乎根本不可能实现,这让我感到不可思议。

大二和Hinton合作

于是我开始四处寻找,结果发现多伦多有一个非常出色且强大的学习研究团队。

我在本科二年级时便开始与 Jeff Hinton(AI之父)合作。

相比硬科学,机器学习的理解更加容易

机器学习确实是一门复杂的科学。

我想这不像物理学。

我认为在物理学、数学以及许多其他硬科学领域,一个人需要掌握大量知识后才能开始发挥作用。

虽然我不太确定,因为我从未涉足这些领域。

这只是我的印象。

而机器学习则更多地是,那些重要的想法,甚至是与前沿研究相关的想法,都离表面非常近。

这个观点和我们如今的现状是如此的吻合。

尤其是在一个远离真正训练前沿的实验室中,在没有特别努力寻找的情况下,周围的机器学习的低垂果实之多令人惊讶。

深度学习之所以有效,很大程度上是因为人们愿意付出努力去把握这些机会。

Ilya认为:

只要有正确的指导和方向,无需多年学习就能理解机器学习背后的主要思想、有效方法的主要理念以及主要的直觉认识。

监督学习是机器学习中最成功的领域

Ilya在访谈中谈到,到目前为止(2015年),监督学习是机器学习中最成功的领域。

主持人随后请Ilya解释他最近的工作,Ilya继续深入讲解了深度学习如何得出答案的另一个核心要点。

所以你说,好,数据会告诉我们最佳的连接方式。

因为深度神经网络是一种非常强大、非常丰富的模型,它可以完成很多复杂的任务。

我们很难想象它有哪些事情是无法做到的。

正因如此,每当我们拥有大型数据集时,我们可以应用一种简单的学习算法来找到最佳的神经网络,并取得良好的结果。

因此,我当时致力于将深度监督学习方法应用于神经网络,解决输入是序列、输出也是序列的问题。

从概念上讲,这与我之前所讨论的内容并没有实质差别,主要是一个技术问题。

其关键在于确保模型能够处理输入和输出都是长度不再预先固定的序列。

但它的基本方法是一样的,并且使用了相同的基本学习算法。

再者,令人惊讶的是,尽管这种方法最终表现得如此强大,它实际上却非常简单易懂。

学习算法极其简单。也许只需要一个小时,一个聪明的学生就能理解它全部的工作原理。

这个观点也和我们当下的现状极度吻合。

不论是LLM还是Transformer,我们都可以在简单学习后,了解它的基本原理。

甚至就像2023年那次采访的题目,为何「预测下一个单词」这么简单的模型就能超越人类的智能。

只是为了增加数据

在Ilya看来,将深度学习中成功的图像分类技术应用到序列分类(即更接近文本)上只是「一个技术细节」。

人们所做的很多工作更像是在为模型构建数据加载器,而不是我们提出的架构本身有多新颖。

Ilya如此注重数据和通用性,那么后来像Transformer这样的架构席卷整个机器学习领域也许并不会让他感到意外。

神经网络的目标函数非常复杂

它高度非凸。

而且从数学上完全没有任何保证能确保优化成功。

因此,如果你和一位研究优化理论的学者讨论,他们会告诉你,从理论上根本没有理由相信这种优化会奏效。

然而,事实证明它确实能成功——这是经验证明的结果。

纯粹靠理论,我们很难解释太多细节。

并不是因为这里有什么「魔法」,而只是说明我们还没完全搞清楚原理。

我们其实不清楚,为什么这些看似简单的启发式优化算法在这些问题上表现得如此出色。

因为没有任何数学定理或理论可以说明它们必然会成功。

我们真正期待的定理,应该反映「在现有条件下做到最好」这种理念。

然而,人类的智慧并不追求绝对最优,就像我们设计飞机或汽车时也不会力求完美。

我们只需要一个「够好」的工程系统就行。

深度学习和非凸优化给我们的,正是一群「够好」的系统。虽然它们可能不是最优解,却依然非常有用、充满潜力。

这就是事实。

深度学习追求的是「够好」

在许多领域,尤其是学术界,人们过度追求最优,反而忽略了真正重要的目标。

深度学习是一门务实的科学,它在现有资源条件下追求「够好」。

随着数据量和算力的飞速增长,「够好」往往就能带来惊人的成果。

这种「够好」的思路,也让现代人工智能更像「炼金术」而非传统科学.

因为传统科学的进展通常要慢得多。

也许正是这种因为深度学习是务实的,在如今算力爆炸和数据丰富的时代,LLM虽然还是「黑箱」,但已经切实的改变了我们的工作和生活。

某种意义上,也算 「预言」了整个LLM时代。

初始化的尺度直接决定了模型的可训性

关于这一点,还有一些不那么直观但非常重要的细节值得讨论。

你可以这样理解:神经网络里有大量神经元和连接,每层都会先将输入乘以随机权重,再经过非线性变换。

第一层处理完后,第二层又会重复相同的过程:乘权重、做非线性变换。

如果这些随机权重太小,信号在多次相乘后就会迅速衰减到几乎为零。

当信号到达输出层时,你几乎感受不到任何输入的影响。

这样一来,学习算法就无法发现输入和输出之间的关联,也就没法改进模型。

因此,我们必须让随机初始化的权重大多数情况下足够大,才能保证输入的变化一路传递到输出层。

一旦满足了这个条件,梯度就能够找到正确的方向,有效地优化网络。

…因此在实际应用中,当研究人员希望在一个真实数据集上训练神经网络时,初始化的尺度是你需要关注的最重要的参数之一。

以上内容节选自音频对话内容,绝大部分来源于Ilya本人。

这就是Ilya 2015年对机器学习的深刻洞察。

那时,距离Transformer发布还有4年,距离ChatGPT发布还有7年的时间。

但是Ilya已经深刻地体会到神经网络的威力。

如果你想要更加深入的了解,可以详细听听上面的

免责声明:本网信息来自于互联网,目的在于传递更多信息,并不代表本网赞同其观点。其内容真实性、完整性不作任何保证或承诺。由用户投稿,经过编辑审核收录,不代表头部财经观点和立场。

证券投资市场有风险,投资需谨慎!请勿添加文章的手机号码、公众号等信息,谨防上当受骗!如若本网有任何内容侵犯您的权益,请及时联系我们。

相关文章

-

软科排名碾压北大! GIS 专业成国家战略刚需担当!

2025-07-042阅读

-

给大热的智能体做体检:关键「安全」问题能达标吗?

2025-07-042阅读

-

科创001|跨越1800公里煎牛排,人形机器人具备了“远程存在”能力

2025-07-042阅读

-

飞船从空间站撤离画面公布:经受1000多℃灼烧后,坠入太平洋

2025-07-042阅读

-

氨基载玻片,核心化学特性

2025-07-042阅读

-

科研攻关、成果转化、国际认证……天府兴隆湖实验室多维发力

2025-07-042阅读

-

CICC科普栏目|量子精密测量如何重新定义世界?

2025-07-042阅读

-

科研攻关、成果转化、国际认证……天府兴隆湖实验室多维发力

2025-07-042阅读

-

家贼难防!2名清华顶尖科学家将赴美效力,网友:教育资源错付了

2025-07-042阅读

-

失序的无人机“飞手”培训市场亟待监管

2025-07-042阅读